LangChain là gì? Cách ứng dụng AI với LLM

LangChain là gì? Trong làn sóng phát triển mạnh mẽ của trí tuệ nhân tạo, các mô hình ngôn ngữ lớn (LLM) như GPT-4, Claude hay LLaMA đang ngày càng chứng minh vai trò quan trọng trong việc xây dựng các ứng dụng AI thông minh và linh hoạt. Tuy nhiên, để khai thác hiệu quả sức mạnh của LLM, lập trình viên cần một nền tảng giúp tổ chức logic xử lý, tích hợp dữ liệu, bộ nhớ, công cụ và các thao tác tương tác phức tạp.

LangChain – một framework mã nguồn mở – đã ra đời để giải quyết chính nhu cầu đó. Trong bài viết này, chúng ta sẽ cùng phân tích chi tiết LangChain, khám phá cách nó hoạt động và lý do vì sao đây đang là lựa chọn hàng đầu cho các nhà phát triển AI hiện đại.

LangChain là gì?

LangChain là một framework mã nguồn mở được thiết kế để giúc developer dễ dàng xây dựng các ứng dụng AI dựa trên các mô hình ngôn ngữ lớn (Large Language Models – LLM) như GPT-4, Claude, Cohere, hay LLaMA. Framework này cho phép xây dựng các “chain” linh hoạt bao gồm nhiều bước xử lý, kết nối giữa LLM với các nguồn dữ liệu, truy vấn, bộ nhớ, công cụ và tư duy logic.

Các thành phần chính trong LangChain

PromptTemplate

Giúp xây dựng các prompt có tham số linh hoạt, tái sử dụng nhiều lần.

from langchain.prompts import PromptTemplate

prompt = PromptTemplate.from_template("Viết một bài viết về {topic}")

print(prompt.format(topic="AI trong giáo dục"))LLM Wrapper

Lớp trích giữa các mô hình AI như OpenAI GPT-3.5, GPT-4, Cohere, HuggingFace Transformers.

from langchain.chat_models import ChatOpenAI

llm = ChatOpenAI(model_name="gpt-4", temperature=0.5)Chain

Chuỗi các bước xử lý kết hợp lại như prompt -> model -> output -> xử lý tiếp.

from langchain.chains import LLMChain

chain = LLMChain(llm=llm, prompt=prompt)

result = chain.run(topic="ứng dụng blockchain trong logistics")

print(result)Memory

Lưu lại lịch sử hội thoại, giúp chatbot nhớ ngữ cảnh và hồi đắp một cách tự nhiên hơn.

from langchain.memory import ConversationBufferMemory

memory = ConversationBufferMemory()Tools & Agents

Cho phép tạo ra các tác nhân AI biết tự truy vấn Google, gọi API, truy cập cơ sở dữ liệu, thực hiện tác vụ như con người.

Đọc thêm: Google Gemini Canvas – một công cụ AI có thể thay đổi cách bạn làm việc và học tập!

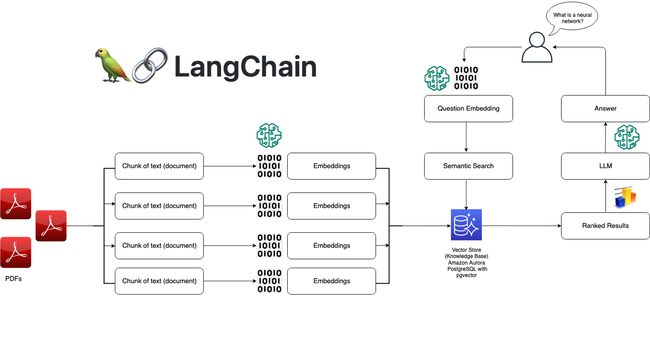

Triển khai thực tế: Xây chatbot Q&A từ file PDF

Bài toán

Tạo chatbot trả lời câu hỏi dựa trên file PDF tài liệu nội bộ (hừu ích cho doanh nghiệp, pháp lý, hỗ trợ khách hàng…)

Các bước:

- Đọc file PDF → chia thành đoạn text ngắn.

- Dùng LangChain + FAISS/ Chroma để indexing theo vector.

- Khi người dùng hỏi → Lấy các đoạn có vector tương đồng cao nhất.

- Đóng gói chúng vào prompt → gọi LLM sinh câu trả lời.

LangChain có sẵn module RetrievalQA để làm việc này chỉ trong vòng 30 dòng code.

Tìm hiểu LangChain Agent

Agent trong LangChain là thành phần cho phép AI tự động quyết định chọn công cụ nào sử dụng, trong thứ tự nào, dựa trên nội dung truy vấn. Rất hữu ích trong việc xây trợ lý ảo biết truy vấn Google, lấy số liệu, gửi email…

So sánh LangChain với LlamaIndex và Haystack

| Framework | Mục đích chính | Điểm mạnh | Hạn chế |

| LangChain | Xây dựng app AI end-to-end | Agent, Memory, Tool, modular cao | Cú pháp Python hơi phức tạp |

| LlamaIndex | Tích hợp dữ liệu ngoại vi vào LLM | RAG tốt, query đa nguồn linh hoạt | Không có Agent |

| Haystack | Triển khai RAG cho doanh nghiệp | Elasticsearch + pipeline rõ ràng | Dành cho team lớn |

Kết luận

LangChain đang dần trở thành tiêu chuẩn thực tế để xây dựng hệ thống AI nhận thức (cognitive applications) như chatbot, trợ lý AI, trình trợ giúss email, QA bot… Nhờ kiến trúc rõ ràng, dễ tích hợp và khả năng mở rộng cao, LangChain rất đáng để dành thời gian nghiên cứu và triển khai thực tế.