Tìm hiểu về cấu trúc Transformer: Công nghệ đằng sau ChatGPT và Bard

Tìm hiểu về cấu trúc Transformer ? Trong thế giới trí tuệ nhân tạo (AI) hiện nay, một thuật ngữ đang dần trở nên quen thuộc và có sức ảnh hưởng mạnh mẽ: Transformer. Đây chính là nền tảng của hàng loạt mô hình AI hiện đại như GPT, BERT, T5, RoBERTa, và nhiều mô hình xử lý ngôn ngữ tự nhiên khác.

Vậy cấu trúc Transformer là gì, vì sao nó lại được xem là “trái tim” của AI thế hệ mới? Hãy cùng LBK.VN khám phá trong bài viết dưới đây.

Transformer là gì?

Transformer là một kiến trúc mạng nơ-ron sâu (deep learning architecture) được giới thiệu vào năm 2017 trong bài báo nổi tiếng “Attention is All You Need”. Khác với các mô hình RNN hay LSTM trước đó, Transformer không xử lý dữ liệu theo tuần tự, mà sử dụng cơ chế self-attention để hiểu và biểu diễn mối quan hệ giữa các phần tử trong chuỗi dữ liệu.

Nhờ đó, Transformer có thể đào tạo song song, hiệu quả hơn, và hiểu ngữ cảnh sâu xa hơn.

Cấu trúc tổng quan của Transformer

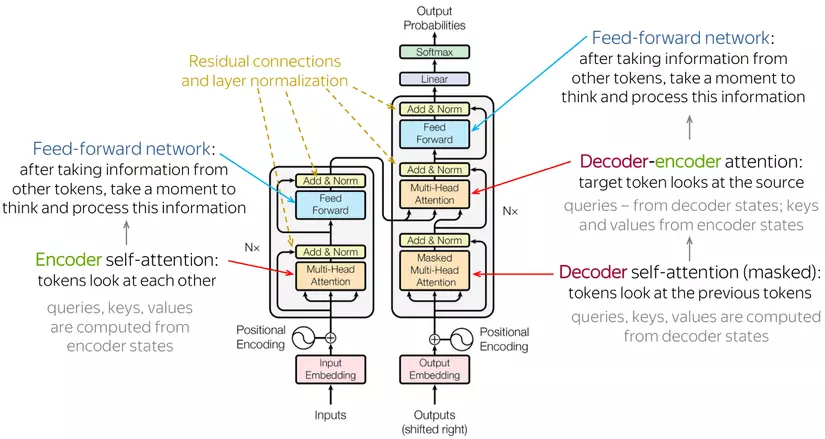

Transformer gồm hai thành phần chính:

-

Encoder: Nhận đầu vào và chuyển nó thành chuỗi vector ẩn có ý nghĩa.

-

Decoder: Dựa vào vector ẩn từ encoder để sinh ra đầu ra (như dịch văn bản, sinh câu…).

Mỗi phần bao gồm nhiều tầng giống nhau (stacked layers), mỗi tầng gồm 2 thành phần quan trọng:

Multi-Head Self-Attention

Đây là thành phần cốt lõi, giúp mô hình hiểu được từ nào trong câu quan trọng với từ nào khác. Multi-head attention chia nhỏ dữ liệu thành nhiều “đầu”, giúp mô hình học được nhiều mối quan hệ ngữ nghĩa khác nhau.

Ví dụ: Trong câu “Hà Nội là thủ đô của Việt Nam”, self-attention giúp mô hình hiểu rằng “Hà Nội” liên quan đến “thủ đô” và “Việt Nam”.

Feed-Forward Neural Network (FFNN)

Sau khi xử lý attention, dữ liệu được đưa qua một mạng nơ-ron đơn giản nhằm tăng độ trừu tượng và khả năng học phi tuyến.

Ngoài ra còn có:

-

Residual Connections: kết nối tắt giữa các lớp, giúp chống mất mát thông tin.

-

Layer Normalization: ổn định quá trình huấn luyện.

-

Positional Encoding: vì không có thứ tự như RNN, nên cần thêm thông tin vị trí từ vào đầu vào.

Đọc thêm: Sự khác biệt giữa PyTorch và TensorFlow: Nên chọn framework nào cho dự án AI của bạn?

Attention – Trái tim của Transformer

Cơ chế attention giúp mô hình “tập trung” vào các phần thông tin quan trọng trong câu. Trong self-attention, mỗi từ sẽ được so sánh với tất cả các từ còn lại để xác định mức độ liên quan.

Công thức attention:

-

Q: Query

-

K: Key

-

V: Value

-

d_k: số chiều của vector Key

Việc sử dụng nhiều “head” trong attention giúp mô hình học được nhiều khía cạnh khác nhau của dữ liệu.

Vì sao Transformer mạnh mẽ?

Kể từ khi ra mắt, cấu trúc Transformer đã nhanh chóng trở thành lựa chọn hàng đầu trong việc xây dựng các mô hình AI hiện đại. Vậy điều gì khiến Transformer trở nên vượt trội hơn so với các kiến trúc trước đó như RNN hay LSTM? Dưới đây là những yếu tố then chốt làm nên sức mạnh của Transformer:

Xử lý song song thay vì tuần tự

Một trong những điểm hạn chế lớn nhất của RNN và LSTM là phải xử lý dữ liệu theo trình tự thời gian. Điều này khiến tốc độ huấn luyện chậm, khó mở rộng.

Ngược lại, Transformer xử lý toàn bộ chuỗi đầu vào cùng lúc nhờ vào cơ chế self-attention. Điều này giúp:

-

Tăng tốc độ huấn luyện đáng kể

-

Tối ưu sử dụng GPU

-

Dễ dàng xử lý văn bản dài hơn

Đây là lý do chính giúp các mô hình như GPT có thể được huấn luyện trên hàng tỷ từ trong thời gian ngắn.

Học mối quan hệ xa trong chuỗi

Self-attention cho phép mô hình hiểu được mối liên kết giữa các từ cách xa nhau, điều mà RNN thường gặp khó khăn. Ví dụ:

Trong câu: “Cuốn sách mà tôi đã đọc tuần trước rất thú vị”, Transformer dễ dàng liên kết “cuốn sách” với “thú vị”, dù chúng cách nhau nhiều từ.

Điều này cực kỳ quan trọng trong các tác vụ cần hiểu ngữ cảnh dài như:

-

Dịch máy

-

Trả lời câu hỏi

-

Tóm tắt văn bản

Cơ chế attention linh hoạt và thông minh

Self-attention giúp mô hình tập trung vào những phần quan trọng nhất của dữ liệu, thay vì xử lý tất cả mọi thứ như nhau. Thêm vào đó, multi-head attention cho phép học nhiều góc nhìn khác nhau trong cùng một lần xử lý.

Ví dụ: Một “head” có thể học quan hệ ngữ pháp, trong khi head khác học quan hệ ngữ nghĩa.

Tính tổng quát và khả năng mở rộng

Transformer không chỉ mạnh ở xử lý ngôn ngữ tự nhiên mà còn được áp dụng thành công trong nhiều lĩnh vực khác, như:

-

Thị giác máy tính (Computer Vision): Vision Transformer (ViT)

-

Sinh học: AlphaFold dự đoán cấu trúc protein

-

Âm thanh và nhạc số: Audio Transformer

Với tính linh hoạt này, Transformer đang trở thành một kiến trúc AI “đa năng”, có thể áp dụng cho gần như mọi loại dữ liệu tuần tự.

Khả năng huấn luyện trên quy mô lớn

Transformer hoạt động cực kỳ hiệu quả với khối lượng dữ liệu lớn và mô hình lớn (large-scale). Điều này giúp tạo ra các mô hình ngôn ngữ khổng lồ như:

-

GPT-4 với hàng trăm tỷ tham số

-

PaLM, LLaMA, Claude AI… đều dựa trên Transformer

Ứng dụng của Transformer trong thực tế

Cấu trúc Transformer là nền tảng của nhiều mô hình AI đột phá:

-

GPT (Generative Pre-trained Transformer): tạo văn bản tự động

-

BERT (Bidirectional Encoder Representations from Transformers): hiểu ngữ cảnh hai chiều

-

T5, RoBERTa, XLNet: cải tiến từ BERT

-

Vision Transformer (ViT): áp dụng cho xử lý ảnh

-

AlphaFold: dự đoán cấu trúc protein 3D

Kết luận

Transformer không chỉ là một kiến trúc mạng nơ-ron mới, mà là một bước ngoặt quan trọng trong sự phát triển của trí tuệ nhân tạo. Cấu trúc này đã và đang làm thay đổi cách AI xử lý ngôn ngữ, hình ảnh, âm thanh và nhiều loại dữ liệu phức tạp khác.

Hiểu rõ cấu trúc Transformer sẽ giúp bạn nắm bắt được cốt lõi của các mô hình AI hiện đại – nền tảng đang định hình tương lai công nghệ.